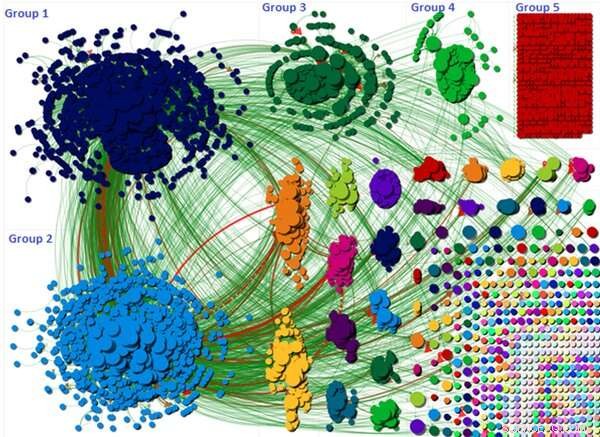

Il grafico mostra come la discussione sulla teoria della cospirazione sia stata suddivisa in diversi gruppi. Credito:Wasim Ahmed, Autore fornito

È opinione diffusa che le teorie del complotto sui social media siano guidate da "bot" dannosi e anonimi creati da terze parti oscure. Ma la mia nuova ricerca, che ha esaminato una teoria della cospirazione COVID-19 di grande successo, ha dimostrato che i normali account dei cittadini possono essere altrettanto colpevoli quando si tratta di diffondere bugie pericolose e disinformazione.

Quest'anno la pandemia ha alimentato almeno dieci teorie del complotto. Alcuni hanno collegato la diffusione della malattia alla rete 5G, con conseguente vandalismo delle antenne telefoniche. Altri hanno sostenuto che il COVID-19 fosse un'arma biologica. La ricerca ha dimostrato che le teorie della cospirazione potrebbero contribuire a far ignorare le regole di allontanamento sociale da parte delle persone.

Il movimento #FilmYourHospital era una di queste teorie. Ha incoraggiato le persone a registrare video di se stessi in luoghi apparentemente vuoti, o poco affollato, ospedali per dimostrare che la pandemia è una bufala. Sono stati condivisi molti video che mostravano corridoi e reparti vuoti.

La nostra ricerca ha cercato di identificare i driver della cospirazione ed esaminare se gli account che l'hanno spinta nell'aprile 2020 fossero robot o persone reali.

Scala della cospirazione

La cospirazione del 5G ha attirato 6, 556 utenti di Twitter nel corso di una sola settimana. Il #FilmYourHospital la cospirazione era molto più grande del 5G, con un totale di 22, 785 tweet inviati in un periodo di sette giorni entro le 11, 333 utenti. Aveva anche un forte sostegno internazionale.

La visualizzazione sopra mostra ogni utente di Twitter come un piccolo cerchio e la discussione complessiva è raggruppata in una serie di gruppi diversi. Questi gruppi sono formati in base al modo in cui gli utenti si menzionavano e si ritwittavano a vicenda.

La visualizzazione evidenzia come i tre gruppi più grandi fossero responsabili della diffusione della cospirazione. Ad esempio, la discussione nei gruppi uno e due era incentrata su un singolo tweet che è stato altamente ritwittato. Il tweet suggeriva che il pubblico veniva fuorviato e che gli ospedali non erano occupati o invasi, come riportato dai media mainstream. Il tweet ha quindi chiesto ad altri utenti di filmare i propri ospedali utilizzando l'hashtag in modo che potesse diventare un argomento di tendenza. Il grafico mostra la portata e la dimensione di questi gruppi.

Dove sono i bot?

Abbiamo utilizzato Botometer per rilevare i bot che attingono a un algoritmo di apprendimento automatico. Lo strumento calcola un punteggio in cui i punteggi bassi indicano il comportamento umano e un punteggio alto indica un bot. Botometer funziona estraendo varie funzionalità da un account come il suo profilo, gli amici, rete sociale, modelli nell'attività temporale, linguaggio e sentimento. Il nostro studio ha preso un campione rappresentativo sistematico del 10% di utenti per eseguire Botometer.

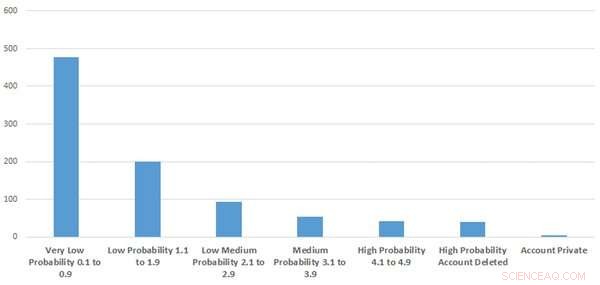

La figura mostra quanti degli account erano sospetti o simili a bot. Credito:Wasim Ahmed, Autore fornito

I nostri risultati hanno indicato che il tasso di account automatizzati era probabilmente basso. Abbiamo usato i punteggi grezzi di Botometer per allegare un'etichetta di probabilità se l'account era probabile che fosse un bot. Questi andavano da molto bassi, basso, probabilità bassa-media e alta.

Nella migliore delle ipotesi, solo il 9,2% del campione che abbiamo esaminato assomigliava a comportamenti di account o bot altamente sospetti. Ciò significa che oltre il 90% degli account che abbiamo esaminato erano probabilmente autentici.

interessante, abbiamo anche scoperto che gli account eliminati e gli account automatici contenevano parole chiave come "Trump" e "Make America Great Again" nella loro biografia utente. Nello stesso periodo il presidente Donald Trump era in disaccordo con i consulenti scientifici su quando revocare le regole di blocco.

Da dove proviene?

Quando abbiamo esaminato gli utenti più influenti collegati all'hashtag, abbiamo scoperto che la teoria della cospirazione era guidata da influenti politici conservatori e attivisti politici di estrema destra. Gli studiosi hanno notato come l'estrema destra abbia sfruttato la pandemia. Per esempio, alcuni hanno creato dei canali su Telegram, un servizio di messaggistica istantanea basato su cloud, per discutere di COVID-19 e amplificare la disinformazione.

Ma una volta che la teoria della cospirazione ha iniziato a suscitare attenzione, è stata sostenuta dai comuni cittadini. La campagna sembrava anche essere supportata e guidata da account Twitter pro-Trump e la nostra ricerca ha rilevato che alcuni account che si comportavano come "bot" e account eliminati tendevano ad essere pro-Trump. È importante notare che non tutti gli account che si comportano come bot sono bot, poiché potrebbero esserci utenti molto attivi che potrebbero ricevere un punteggio elevato. E, al contrario, non tutti i bot sono dannosi poiché alcuni sono stati impostati per scopi legittimi.

Gli utenti di Twitter hanno spesso condiviso video di YouTube a sostegno della teoria e YouTube è stata una fonte influente.

Si possono fermare?

Le organizzazioni di social media possono monitorare account e contenuti sospetti e se violano i termini di servizio, il contenuto dovrebbe essere rimosso rapidamente. Twitter ha sperimentato l'applicazione di etichette di avviso sui tweet. Inizialmente non ha avuto successo perché Twitter ha accidentalmente etichettato erroneamente alcuni tweet, che potrebbe aver inavvertitamente spinto ulteriormente le cospirazioni. Ma se riescono a mettere insieme una tecnica di etichettatura migliore, questo potrebbe essere un metodo efficace.

Le cospirazioni possono essere contrastate anche fornendo informazioni affidabili, fornite dalle autorità sanitarie pubbliche e dagli "influencer" della cultura popolare. Ad esempio, Consiglio comunale di Oldham nel Regno Unito, ha chiesto l'aiuto dell'attore James Buckley, famoso per il suo ruolo di Jay nella sitcom E4 The Inbetweeners, per diffondere messaggi di salute pubblica.

E altre ricerche evidenziano che spiegare argomenti errati e descrivere il consenso scientifico può aiutare a ridurre l'effetto della disinformazione.. Purtroppo, indipendentemente dalle procedure e dai passaggi messi in atto, ci saranno sempre persone che crederanno alle cospirazioni. L'onere deve essere sulle piattaforme per assicurarsi che queste teorie non si diffondano così facilmente.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.