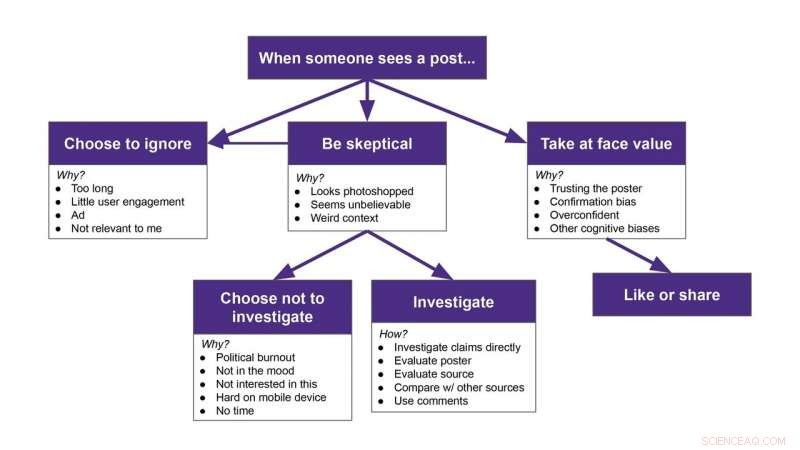

I partecipanti hanno avuto varie reazioni di fronte a un post falso:alcuni lo hanno completamente ignorato, alcuni l'hanno preso alla lettera, alcuni hanno indagato se fosse vero, e alcuni ne erano sospettosi, ma poi hanno scelto di ignorarlo. Credito:Franziska Roesner/Università di Washington

Piattaforme di social media, come Facebook e Twitter, fornire alle persone molte informazioni, ma sta diventando sempre più difficile dire cosa è reale e cosa non lo è.

I ricercatori dell'Università di Washington volevano sapere come le persone indagavano sui post potenzialmente sospetti sui propri feed. Il team ha visto 25 partecipanti scorrere i propri feed di Facebook o Twitter mentre, a loro insaputa, un'estensione di Google Chrome ha aggiunto in modo casuale contenuti smascherati in cima ad alcuni dei post reali. I partecipanti hanno avuto varie reazioni di fronte a un post falso:alcuni lo hanno completamente ignorato, alcuni l'hanno preso alla lettera, alcuni hanno indagato se fosse vero, e alcuni ne erano sospettosi, ma poi hanno scelto di ignorarlo. Questi risultati sono stati accettati alla conferenza ACM CHI 2020 sui fattori umani nei sistemi informatici.

"Volevamo capire cosa fanno le persone quando incontrano notizie false o disinformazione nei loro feed. Se ne accorgono? Cosa fanno al riguardo?" ha detto l'autore senior Franziska Roesner, un professore associato di UW presso la Paul G. Allen School of Computer Science &Engineering. "Ci sono molte persone che stanno cercando di essere buoni consumatori di informazioni e stanno lottando. Se riusciamo a capire cosa stanno facendo queste persone, potremmo essere in grado di progettare strumenti che possano aiutarli".

Ricerche precedenti su come le persone interagiscono con la disinformazione chiedevano ai partecipanti di esaminare il contenuto di un account creato da un ricercatore, non da qualcuno che hanno scelto di seguire.

"Ciò potrebbe rendere le persone automaticamente sospettose, " ha detto l'autrice principale Christine Geeng, uno studente di dottorato UW nella Allen School. "Ci siamo assicurati che tutti i post sembrassero provenire da persone seguite dai nostri partecipanti".

I ricercatori hanno reclutato partecipanti di età compresa tra 18 e 74 anni provenienti da tutta l'area di Seattle, spiegando che il team era interessato a vedere come le persone utilizzano i social media. I partecipanti hanno utilizzato Twitter o Facebook almeno una volta alla settimana e spesso hanno utilizzato le piattaforme dei social media su un laptop.

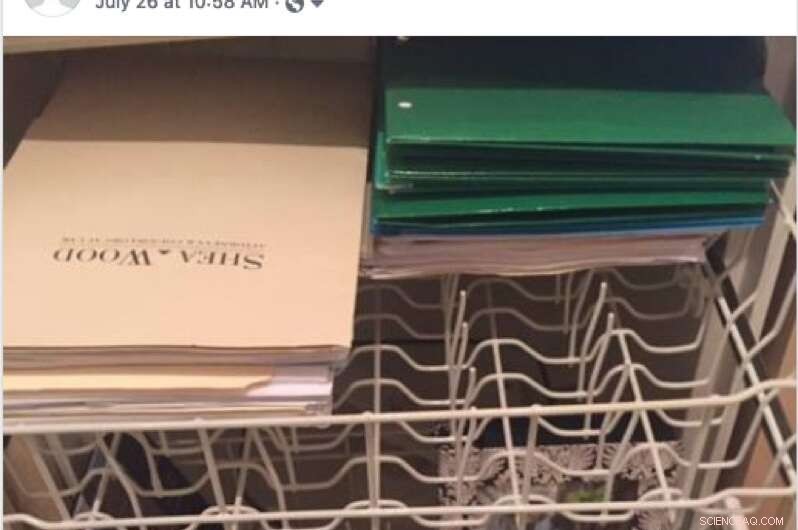

Un esempio di post falso che un partecipante potrebbe vedere sul proprio feed di Facebook durante lo studio. Un partecipante ha menzionato di aver saltato questo post perché ha visto la parola "Florida" e ha deciso che non riguardava loro. Credito:Conferenza Geeng et al./2020 ACM CHI sui fattori umani nei sistemi informatici

Quindi il team ha sviluppato un'estensione di Chrome che aggiungeva in modo casuale post o meme falsi che erano stati sfatati dal sito Web di verifica dei fatti Snopes.com sopra i post reali per far sembrare temporaneamente che fossero condivisi dalle persone sui feed dei partecipanti. Quindi, invece di vedere il post di un cugino su una vacanza recente, un partecipante vedrebbe invece il cugino condividere una delle storie false.

I ricercatori hanno installato l'estensione sul laptop del partecipante o il partecipante ha effettuato l'accesso ai propri account sul laptop del ricercatore, che aveva l'estensione abilitata. Il team ha detto ai partecipanti che l'estensione avrebbe modificato i loro feed (i ricercatori non hanno detto come) e avrebbe tenuto traccia dei loro Mi piace e delle condivisioni durante lo studio, tuttavia, infatti, non stava tracciando nulla. L'estensione è stata rimossa dai laptop dei partecipanti alla fine dello studio.

"Faremmo loro scorrere i feed con l'estensione attiva, " Geeng ha detto. "Ho detto loro di pensare ad alta voce a cosa stavano facendo o cosa avrebbero fatto se si fossero trovati in una situazione senza di me nella stanza. Quindi la gente parlerebbe di 'Oh sì, leggerei questo articolo, ' o 'Lo salterei.' A volte facevo domande come, 'Perché stai saltando questo? Perché ti piacerebbe?'"

I partecipanti non potevano effettivamente mettere mi piace o condividere i post falsi. Su Twitter, un "retweet" condividerebbe il contenuto reale sotto il post falso. L'unica volta che un partecipante ha ritwittato il contenuto sotto il post falso, i ricercatori li hanno aiutati a annullarlo dopo che lo studio era finito. Su Facebook, i pulsanti Mi piace e Condividi non funzionavano affatto.

Dopo che i partecipanti hanno riscontrato tutti i post falsi, nove per Facebook e sette per Twitter, i ricercatori hanno interrotto lo studio e hanno spiegato cosa stava succedendo.

"Non era come abbiamo detto, 'Hey, c'erano dei post falsi lì dentro.' Noi abbiamo detto, 'È difficile individuare la disinformazione. Ecco tutti i post falsi che hai appena visto. Questi erano falsi, e i tuoi amici non li hanno davvero pubblicati, '", ha detto Geeng. "Il nostro obiettivo non era quello di ingannare i partecipanti o di farli sentire esposti. Volevamo normalizzare la difficoltà di determinare cosa è falso e cosa non lo è".

Un esempio di post falso che un partecipante potrebbe vedere sul proprio feed di Facebook durante lo studio. Credito:Conferenza Geeng et al./2020 ACM CHI sui fattori umani nei sistemi informatici

I ricercatori hanno concluso l'intervista chiedendo ai partecipanti di condividere quali tipi di strategie utilizzano per rilevare la disinformazione.

Generalmente, the researchers found that participants ignored many posts, especially those they deemed too long, overly political or not relevant to them.

But certain types of posts made participants skeptical. Per esempio, people noticed when a post didn't match someone's usual content. Sometimes participants investigated suspicious posts—by looking at who posted it, evaluating the content's source or reading the comments below the post—and other times, people just scrolled past them.

"I am interested in the times that people are skeptical but then choose not to investigate. Do they still incorporate it into their worldviews somehow?" Roesner said. "At the time someone might say, 'That's an ad. I'm going to ignore it.' But then later do they remember something about the content, and forget that it was from an ad they skipped? That's something we're trying to study more now."

While this study was small, it does provide a framework for how people react to misinformation on social media, ha detto la squadra. Now researchers can use this as a starting point to seek interventions to help people resist misinformation in their feeds.

"Participants had these strong models of what their feeds and the people in their social network were normally like. They noticed when it was weird. And that surprised me a little, " Roesner said. "It's easy to say we need to build these social media platforms so that people don't get confused by fake posts. But I think there are opportunities for designers to incorporate people and their understanding of their own networks to design better social media platforms."