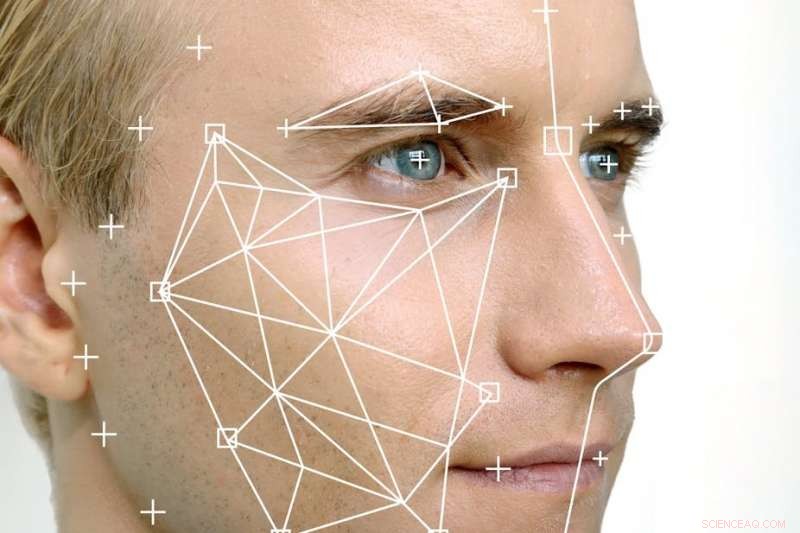

Ci sono molte domande su come la tecnologia di riconoscimento facciale può interferire con i diritti alla privacy delle persone e se peggiorerà la discriminazione nelle pratiche di polizia. Credito:Shutterstock

L'uso della tecnologia di riconoscimento facciale automatizzato (FRT) sta diventando sempre più comune a livello globale, in particolare in Cina, Regno Unito e ora Australia.

FRT significa che possiamo identificare gli individui sulla base di un'analisi delle loro caratteristiche geometriche facciali, tracciando un confronto tra un algoritmo creato dall'immagine catturata e uno già memorizzato, come la patente di guida, custodia immagine o account di social media.

FRT dispone di numerose applicazioni del settore pubblico e privato quando è necessaria la verifica dell'identità. Questi includono l'accesso a un'area protetta, sbloccare un dispositivo mobile o salire su un aereo. È anche in grado di riconoscere gli stati d'animo delle persone, reazioni e, apparentemente, sessualità.

Ed è più prezioso per la polizia rispetto alle normali telecamere CCTV in quanto può identificare le persone in tempo reale e collegarle alle immagini memorizzate. Questo è di immenso valore per lo stato nelle indagini penali, operazioni antiterrorismo e controllo delle frontiere.

Come incide sui diritti alla privacy

Ma il dispiegamento di FRT, già utilizzato dall'AFP e dalle forze di polizia di Stato e da aziende private altrove (aeroporti, impianti sportivi, banche e centri commerciali), è sotto-regolamentato e si basa su algoritmi discutibili che non sono pubblicamente trasparenti.

Questa tecnologia ha importanti implicazioni per i diritti alla privacy delle persone, e il suo utilizzo può peggiorare i pregiudizi e le discriminazioni esistenti nelle pratiche di polizia.

L'uso di FRT incide sui diritti alla privacy creando un algoritmo di caratteristiche personali uniche. Questo a sua volta riduce le caratteristiche delle persone a dati e ne consente il monitoraggio e la sorveglianza. Tali dati e immagini verranno inoltre conservati per un certo periodo di tempo, aprendo la possibilità di hacking o frode.

Inoltre, La FRT può esporre le persone a potenziali discriminazioni in due modi. Primo, le agenzie statali possono abusare delle tecnologie in relazione a determinati gruppi demografici, se intenzionalmente o meno.

E in secondo luogo, ricerca indica che le minoranze etniche, le persone di colore e le donne sono erroneamente identificate da FRT a tassi più elevati rispetto al resto della popolazione. Questa imprecisione può portare i membri di determinati gruppi a essere soggetti a misure di sicurezza o di polizia dalla mano pesante e i loro dati vengono conservati in modo inappropriato.

Ciò è particolarmente rilevante in relazione alle comunità che sono già prese di mira in modo sproporzionato in Australia.

Cosa stanno cercando di fare i legislatori

Il Parlamento ha elaborato un disegno di legge nel tentativo di regolamentare questo spazio, ma lascia molto a desiderare. Il disegno di legge è attualmente in seconda lettura; non è stata fissata una data per il voto.

Se superato, il disegno di legge consentirebbe lo scambio di informazioni sull'identità tra il governo del Commonwealth, governi statali e territoriali e "enti non governativi" (che non sono stati specificati) attraverso la creazione di un hub centrale chiamato "The Capability", così come la soluzione di riconoscimento facciale della patente di guida nazionale, un database di informazioni contenute nei documenti di identità del governo, come le patenti di guida.

Il disegno di legge autorizzerebbe inoltre il Dipartimento degli affari interni a riscuotere, utilizzare e condividere informazioni di identificazione in relazione a una serie di attività, come la prevenzione delle frodi, forze dell'ordine, sicurezza della comunità, e sicurezza stradale.

Sarebbe di gran lunga preferibile che tale legislazione consentisse la condivisione dell'identità solo per una gamma limitata di reati gravi. Come è scritto, questo disegno di legge si riferisce a persone che non sono state condannate per alcun reato - e, infatti, non deve essere sospettato di alcun reato.

Anche, il popolo australiano non ha acconsentito alla condivisione dei propri dati in questo modo. Tale condivisione avrebbe un effetto sproporzionato sul nostro diritto alla privacy.

È importante sottolineare che la violazione del diritto alla privacy è aggravata dal fatto che il disegno di legge consentirebbe al settore privato di accedere ai servizi di identificazione delle identità. Sebbene il settore privato utilizzi già in una certa misura le tecnologie di confronto e verifica delle immagini, come ad esempio da parte delle banche che cercano di individuare il riciclaggio di denaro sporco, il disegno di legge estenderebbe questo. Il disegno di legge non prevede tutele o sanzioni sufficienti per i soggetti privati se utilizzano l'hub oi dati delle persone in modo inappropriato.

La prevalenza di falsi positivi nelle corrispondenze di identità

In senso pratico, ci sono anche preoccupazioni per l'affidabilità e l'accuratezza della FRT, che si sta sviluppando rapidamente ma non è esente da grossi problemi. Resta da vedere se questi problemi sono solo bug o una funzionalità di FRT.

L'esperienza del Regno Unito illustra chiaramente questi problemi. Polizia del Galles del Sud, il leader nazionale britannico sulla tecnologia di riconoscimento facciale, utilizzato il sistema sviluppato da una società australiana privata chiamata Neoface in 18 incontri pubblici tra maggio 2017 e marzo 2018. Ha rilevato che il 91% delle partite, o 2, 451 istanze, erroneamente identificato membri innocenti del pubblico come in una lista di controllo. La supervisione manuale del programma ha rivelato che le partite erano falsi positivi.

Anche la London Metropolitan Police sta eseguendo un pilota FRT. Ha registrato cifre un po' migliori, ma aveva ancora un tasso di identificazione di falsi negativi del 30% al carnevale di Notting Hill e del 22% al giorno della memoria, entrambi nel 2017.

Da segnalare anche il ruolo centrale delle aziende private nello sviluppo di questa tecnologia. Gli algoritmi FRT sono brevettati, e non vi è alcuna indicazione pubblicamente disponibile della misurazione o dello standard che rappresenti una "corrispondenza" di identità.

Legiferare in modo rapido, lo spazio tecnologicamente guidato non è un compito invidiabile. C'è qualche vantaggio in un certo grado di flessibilità nelle definizioni e regole legali in modo che la legge non diventi statica e ridondante troppo presto. Ma anche l'interpretazione più generosa del disegno di legge ammetterebbe che si tratta di un modo imperfetto di regolare l'uso di una tecnologia potente e problematica che è qui per restare, piace o no.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.