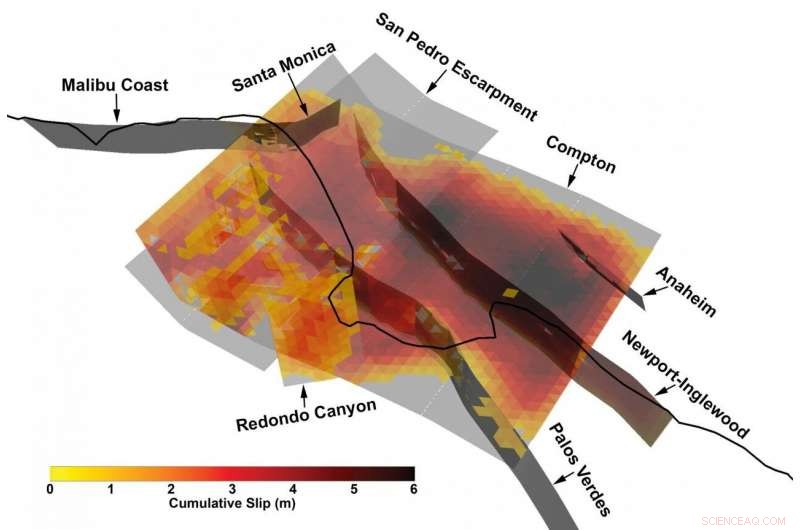

Vista 3D di una rottura multifaglia particolarmente complessa dal catalogo sintetico dei terremoti sviluppato dal Southern California Earthquake Center utilizzando un nuovo framework di modellazione dei terremoti. Credito:Kevin Milner, Università della California del Sud

I terremoti massicci sono, fortunatamente, eventi rari. Ma quella scarsità di informazioni ci rende ciechi in qualche modo ai loro rischi, soprattutto quando si tratta di determinare il rischio per una posizione o una struttura specifica.

"Non abbiamo osservato la maggior parte dei possibili eventi che potrebbero causare danni ingenti, "ha spiegato Kevin Milner, un informatico e ricercatore in sismologia presso il Southern California Earthquake Center (SCEC) presso la University of Southern California. "Usando come esempio la California del sud, non abbiamo avuto un terremoto veramente grande dal 1857, quella è stata l'ultima volta che il sud di San Andreas ha fatto irruzione in un enorme terremoto di magnitudo 7,9. Un terremoto di San Andreas potrebbe avere un impatto su un'area molto più ampia del terremoto di Northridge del 1994, e possono verificarsi anche altri grandi terremoti. Questo è ciò che ci preoccupa".

Il modo tradizionale per aggirare questa mancanza di dati consiste nello scavare trincee per saperne di più sulle rotture passate, raccogliere informazioni da molti terremoti in tutto il mondo e creare un modello statistico di rischio, o utilizzando supercomputer per simulare un terremoto specifico in un luogo specifico con un alto grado di fedeltà.

Però, un nuovo quadro per prevedere la probabilità e l'impatto dei terremoti su un'intera regione, sviluppato da un team di ricercatori associati a SCEC nell'ultimo decennio, ha trovato una via di mezzo e forse un modo migliore per accertare il rischio.

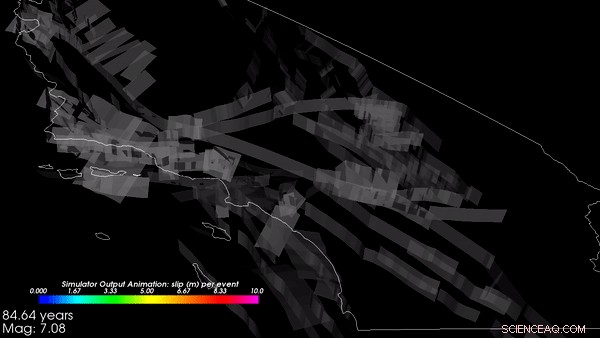

Un nuovo studio condotto da Milner e Bruce Shaw della Columbia University, pubblicato in Bollettino della Società Sismologica d'America nel gennaio 2021, presenta i risultati di un prototipo di simulatore di terremoti Rate-State, o RSQSim, che simula centinaia di migliaia di anni di storia sismica in California. Accoppiato con un altro codice, CyberShake, il framework può calcolare la quantità di scuotimento che si verificherebbe per ogni terremoto. I loro risultati si confrontano bene con i terremoti storici e i risultati di altri metodi, e visualizzare una distribuzione realistica delle probabilità di terremoto.

Secondo gli sviluppatori, il nuovo approccio migliora la capacità di individuare quanto grande potrebbe verificarsi un terremoto in un determinato luogo, consentendo agli sviluppatori di codice di costruzione, architetti, e ingegneri strutturali per progettare edifici più resilienti in grado di sopravvivere ai terremoti in un sito specifico.

"Per la prima volta, abbiamo un'intera pipeline dall'inizio alla fine in cui il verificarsi di terremoti e la simulazione del movimento del suolo sono basati sulla fisica, " ha detto Milner. "Può simulare fino a 100, Migliaia di anni su un sistema di faglie davvero complicato."

Applicare un'enorme potenza del computer a grandi problemi

RSQSim trasforma le rappresentazioni matematiche delle forze geofisiche in gioco nei terremoti, il modello standard di come le rotture si nucleano e si propagano, in algoritmi, e poi li risolve su alcuni dei supercomputer più potenti del pianeta. La ricerca ad alta intensità di calcolo è stata resa possibile per diversi anni da supercomputer sponsorizzati dal governo presso il Texas Advanced Computing Center, tra cui Frontera, il sistema più potente di qualsiasi università del mondo, Blue Waters presso il National Center for Supercomputing Applications, e Summit presso l'Oak Ridge Leadership Computing Facility.

"Un modo in cui potremmo essere in grado di fare meglio nella previsione del rischio è attraverso la modellazione basata sulla fisica, sfruttando la potenza di sistemi come Frontera per eseguire simulazioni, " ha detto Milner. "Invece di una distribuzione statistica empirica, simuliamo il verificarsi di terremoti e la propagazione delle sue onde."

"Abbiamo fatto molti progressi su Frontera nel determinare che tipo di terremoti possiamo aspettarci, su quale colpa, e quanto spesso, "ha detto Christine Goulet, Direttore esecutivo per le scienze applicate presso SCEC, anche coinvolto nel lavoro. "Non prescriviamo o diciamo al codice quando si verificheranno i terremoti. Lanciamo una simulazione di centinaia di migliaia di anni, e lascia che il codice trasferisca lo stress da un errore all'altro."

Le simulazioni sono iniziate con la topografia geologica della California e hanno simulato oltre 800, 000 anni virtuali come gli stress si formano e si dissipano mentre le forze tettoniche agiscono sulla Terra. Da queste simulazioni, la struttura ha generato un catalogo, una registrazione che un terremoto si è verificato in un determinato luogo con una certa magnitudo e attributi in un dato momento. Il catalogo che il team SCEC ha prodotto su Frontera e Blue Waters è stato tra i più grandi mai realizzati, disse Goulet. Gli output di RSQSim sono stati quindi inseriti in CyberShake che ha utilizzato nuovamente modelli geofisici computerizzati per prevedere la quantità di scuotimento (in termini di accelerazione del suolo, o velocità, e durata) si verificherebbe a seguito di ciascun terremoto.

"Il framework fornisce una cronologia completa dei tempi di scorrimento:dove si verifica una rottura e come è cresciuta, " ha spiegato Milner. "Abbiamo scoperto che produce movimenti del suolo realistici, che ci dice che la fisica implementata nel modello funziona come previsto." Hanno più lavoro pianificato per la convalida dei risultati, che è fondamentale prima dell'accettazione per le domande di progettazione.

I ricercatori hanno scoperto che il framework RSQSim produce ricche, terremoti variabili in generale, un segno che sta producendo risultati ragionevoli, generando anche effetti di origine e percorso ripetibili.

Un 3 selezionato a caso, Segmento di 000 anni del catalogo simulato basato sulla fisica dei terremoti in California, creato su Frontera. Credito:Kevin Milner, Università della California del Sud

"Per molti siti, il rischio di scuotimento diminuisce, rispetto alle stime dello stato di pratica", ha detto Milner. "Ma per un paio di siti che hanno configurazioni speciali di faglie vicine o caratteristiche geologiche locali, come vicino a San Bernardino, il pericolo è aumentato. Stiamo lavorando per comprendere meglio questi risultati e per definire approcci per verificarli".

Il lavoro sta aiutando a determinare la probabilità che un terremoto si verifichi lungo una qualsiasi delle centinaia di faglie sismiche della California, la portata del terremoto che ci si poteva aspettare, e come potrebbe innescare altri terremoti.

Il sostegno al progetto arriva dall'U.S. Geological Survey (USGS), Fondazione Nazionale della Scienza (NSF), e il W.M. Fondazione Keck. Frontera è la risorsa nazionale di classe dirigente di NSF. Il tempo di calcolo su Frontera è stato fornito a SCEC tramite un premio Large-Scale Community Partnership (LSCP) che consente a centinaia di studiosi statunitensi di accedere alla macchina per studiare molti aspetti della scienza dei terremoti. I premi LSCP forniscono stanziamenti estesi fino a tre anni per sostenere sforzi di ricerca di lunga durata. SCEC, che è stata fondata nel 1991 e ha calcolato su sistemi TACC per oltre un decennio, è un ottimo esempio di tale sforzo.

La creazione del catalogo ha richiesto otto giorni di elaborazione continua su Frontera e ne ha utilizzati più di 3, 500 processori in parallelo. La simulazione del terremoto in 10 siti in tutta la California ha richiesto una quantità di elaborazione comparabile su Summit, il secondo supercomputer più veloce al mondo.

"L'adozione da parte della comunità più ampia sarà comprensibilmente lenta, " ha detto Milner. "Poiché tali risultati avranno un impatto sulla sicurezza, fa parte della nostra due diligence assicurarci che questi risultati siano tecnicamente difendibili dalla comunità più ampia, " ha aggiunto Goulet. Ma risultati di ricerca come questi sono importanti per andare oltre i codici edilizi generalizzati che in alcuni casi possono rappresentare in modo inadeguato il rischio che una regione deve affrontare mentre in altri casi sono troppo conservativi.

"La speranza è che questi tipi di modelli ci aiutino a caratterizzare meglio il rischio sismico, quindi stiamo spendendo le nostre risorse per costruire forti, sicuro, edifici resilienti dove sono più necessari, " ha detto Milner.