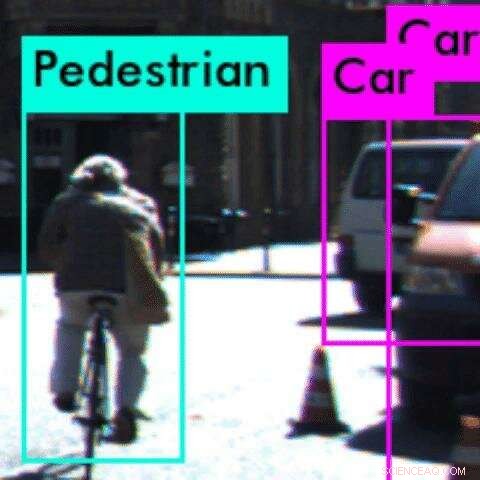

In questo esempio, un algoritmo di percezione classifica erroneamente il ciclista come pedone Credito:Anand Balakrishnan

È una grande domanda per molte persone in città ad alta densità di traffico come Los Angeles:quando arriveranno le auto a guida autonoma? Ma a seguito di una serie di incidenti di alto profilo negli Stati Uniti, problemi di sicurezza potrebbero portare il sogno autonomo a una brusca battuta d'arresto.

All'USC, i ricercatori hanno pubblicato un nuovo studio che affronta un problema di vecchia data per gli sviluppatori di veicoli autonomi:testare gli algoritmi di percezione del sistema, che consentono all'auto di "capire" ciò che "vede".

Lavorando con ricercatori dell'Arizona State University, il nuovo metodo matematico del team è in grado di identificare anomalie o bug nel sistema prima che l'auto colpisca la strada.

Gli algoritmi di percezione sono basati su reti neurali convoluzionali, alimentato dall'apprendimento automatico, un tipo di apprendimento profondo. Questi algoritmi sono notoriamente difficili da testare, poiché non capiamo appieno come fanno le loro previsioni. Ciò può portare a conseguenze devastanti in sistemi critici per la sicurezza come i veicoli autonomi.

"Rendere robusti gli algoritmi di percezione è una delle sfide principali per i sistemi autonomi, " ha detto l'autore principale dello studio Anand Balakrishnan, un dottorato di ricerca in informatica USC. alunno.

"Utilizzando questo metodo, gli sviluppatori possono restringere gli errori negli algoritmi di percezione molto più velocemente e utilizzare queste informazioni per addestrare ulteriormente il sistema. Allo stesso modo in cui le auto devono superare i crash test per garantire la sicurezza, questo metodo offre un test preventivo per rilevare gli errori nei sistemi autonomi."

La carta, intitolato Specificazione e valutazione delle metriche di qualità per i sistemi di percezione basati sulla visione, è stato presentato al Design, Convegno Automation and Test in Europe in Italia, 28 marzo.

Imparare a conoscere il mondo

I veicoli tipicamente autonomi "imparano" a conoscere il mondo tramite sistemi di apprendimento automatico, che vengono alimentati da enormi set di dati di immagini stradali prima che possano identificare gli oggetti da soli.

Ma il sistema può andare storto. Nel caso di un incidente mortale tra un'auto a guida autonoma e un pedone in Arizona lo scorso marzo, il software ha classificato il pedone come "falso positivo" e ha deciso che non era necessario fermarsi.

"Abbiamo pensato, chiaramente c'è qualche problema con il modo in cui questo algoritmo di percezione è stato addestrato, ", ha affermato il coautore dello studio Jyo Deshmukh, un professore di informatica della USC ed ex ingegnere di ricerca e sviluppo per Toyota, specializzato in sicurezza dei veicoli autonomi.

"Quando un essere umano percepisce un video, ci sono alcuni presupposti sulla persistenza che utilizziamo implicitamente:se vediamo un'auto all'interno di un fotogramma video, ci aspettiamo di vedere un'auto in una posizione vicina nel fotogramma video successivo. Questa è una delle numerose "condizioni di sanità mentale" che vogliamo che l'algoritmo di percezione soddisfi prima dell'implementazione".

Per esempio, un oggetto non può apparire e scomparire da un fotogramma all'altro. Se lo fa, viola una "condizione di sanità mentale, " o legge fondamentale della fisica, il che suggerisce che c'è un bug nel sistema di percezione.

Deshmukh e il suo dottorato di ricerca. studente Balakrishnan, insieme a USC Ph.D. studente Xin Qin e studente di master Aniruddh Puranic, ha collaborato con tre ricercatori dell'Arizona State University per indagare sul problema.

Non c'è spazio per errori

Il team ha formulato una nuova logica matematica, chiamato Timed Quality Temporal Logic, e lo ha utilizzato per testare due popolari strumenti di apprendimento automatico, Squeeze Det e YOLO, utilizzando set di dati video grezzi di scene di guida.

La logica si è perfezionata con successo sui casi in cui gli strumenti di apprendimento automatico violavano le "condizioni di sanità mentale" su più fotogrammi del video. Più comunemente, i sistemi di apprendimento automatico non sono riusciti a rilevare un oggetto o hanno classificato erroneamente un oggetto.

Ad esempio, in un esempio, il sistema non è riuscito a riconoscere un ciclista da dietro, quando il pneumatico della bici sembrava una sottile linea verticale. Anziché, ha erroneamente classificato il ciclista come pedone. In questo caso, il sistema potrebbe non riuscire ad anticipare correttamente la prossima mossa del ciclista, che potrebbe portare a un incidente.

Anche gli oggetti fantasma, in cui il sistema percepisce un oggetto quando non ce n'è, erano comuni. Ciò potrebbe far sbattere erroneamente l'auto sui freni, un'altra mossa potenzialmente pericolosa.

Il metodo del team potrebbe essere utilizzato per identificare anomalie o bug nell'algoritmo di percezione prima della distribuzione su strada e consente allo sviluppatore di individuare problemi specifici.

L'idea è di rilevare i problemi con l'algoritmo di percezione nei test virtuali, rendendo gli algoritmi più sicuri e affidabili. In modo cruciale, perché il metodo si basa su una libreria di "condizioni di sanità mentale, " non è necessario che gli esseri umani etichettino gli oggetti nel set di dati di test, un processo che richiede tempo e spesso fallisce.

Nel futuro, il team spera di incorporare la logica per riqualificare gli algoritmi di percezione quando rileva un errore. Potrebbe anche essere esteso all'uso in tempo reale, mentre l'auto è in marcia, come monitor di sicurezza in tempo reale.