Il software e la tecnologia possono elaborare grandi quantità di dati istantaneamente, il che li rende estremamente interessanti per l'uso da parte del governo. Credito:Shutterstock

Nel 2019, l'ex relatore speciale delle Nazioni Unite Philip Alston si è detto preoccupato che stessimo "inciampando come zombi in una distopia del benessere digitale". Aveva studiato come le agenzie governative di tutto il mondo si stessero rivolgendo a sistemi decisionali automatizzati (ADS) per tagliare i costi, aumentare l'efficienza e indirizzare le risorse. Gli ADS sono sistemi tecnici progettati per aiutare o sostituire il processo decisionale umano utilizzando algoritmi.

Alston era preoccupato per una buona ragione. La ricerca mostra che l'ADS può essere utilizzato in modi che discriminano, esacerbano le disuguaglianze, violano i diritti, classificano le persone in diversi gruppi sociali, limitano erroneamente l'accesso ai servizi e intensificano la sorveglianza.

Ad esempio, le famiglie sono andate in bancarotta e costrette a crisi dopo essere state falsamente accusate di frode sui sussidi.

I ricercatori hanno identificato come i sistemi di riconoscimento facciale e gli strumenti di valutazione del rischio abbiano maggiori probabilità di identificare erroneamente le persone con carnagioni più scure e le donne. Questi sistemi hanno già portato ad arresti illeciti e decisioni di condanna male informate.

Spesso, le persone scoprono di essere state interessate da un'applicazione ADS solo quando accade una di queste due cose:dopo che le cose sono andate male, come è successo con lo scandalo dei livelli A nel Regno Unito; o quando le controversie vengono rese pubbliche, come nel caso dell'uso della tecnologia di riconoscimento facciale in Canada e negli Stati Uniti.

Problemi automatizzati

Una maggiore trasparenza, responsabilità, responsabilità e coinvolgimento pubblico nella progettazione e nell'uso di ADS è importante per proteggere i diritti e la privacy delle persone. Ci sono tre ragioni principali per questo:

Il nostro ultimo progetto di ricerca, Automating Public Services:Learning from Canceled Systems , fornisce risultati volti ad aiutare a prevenire danni e contribuire a dibattiti e azioni significative. Il rapporto fornisce la prima panoramica completa dei sistemi cancellati nelle democrazie occidentali.

La ricerca dei fattori e delle motivazioni che portano alla cancellazione dei sistemi ADS ci aiuta a comprendere meglio i loro limiti. Nel nostro rapporto, abbiamo identificato 61 annunci pubblicitari che sono stati cancellati in Australia, Canada, Europa, Nuova Zelanda e Stati Uniti. Presentiamo un resoconto dettagliato dei sistemi annullati nelle aree di rilevamento delle frodi, assistenza all'infanzia e polizia. I nostri risultati dimostrano l'importanza di un'attenta considerazione e della preoccupazione per l'equità.

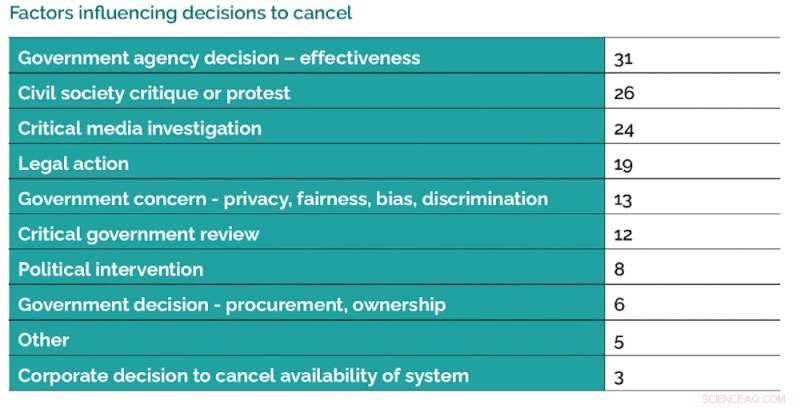

Ci sono una serie di fattori che influenzano le decisioni di annullare gli usi dei sistemi ADS. Credito:Data Justice Lab, autore fornito

Motivi dell'annullamento

Ci sono una serie di fattori che influenzano le decisioni di annullare gli usi di ADS. Una delle nostre scoperte più importanti è la frequenza con cui i sistemi vengono cancellati perché non sono efficaci come previsto. Un altro risultato chiave è il ruolo significativo svolto dalla mobilitazione e dalla ricerca della comunità, dalla rendicontazione investigativa e dall'azione legale.

I nostri risultati dimostrano che ci sono comprensioni, visioni e politiche contrastanti che circondano l'uso di ADS.

Si spera che i nostri consigli portino a una maggiore partecipazione civica e a una migliore supervisione, responsabilità e prevenzione dei danni.

Nel rapporto, indichiamo le richieste diffuse ai governi di istituire registri ADS dotati di risorse come primo passo fondamentale verso una maggiore trasparenza. Alcuni paesi come il Regno Unito hanno dichiarato l'intenzione di farlo, mentre altri paesi come il Canada devono ancora muoversi in questa direzione.

I nostri risultati dimostrano che l'uso di ADS può portare a una maggiore disuguaglianza e ingiustizia sistemica. Ciò rafforza la necessità di prestare attenzione a come l'uso di ADS può creare sistemi differenziali di vantaggio e svantaggio.

Responsabilità e trasparenza

Gli ADS devono essere sviluppati con cura e responsabilità impegnandosi in modo significativo con le comunità colpite. Possono esserci conseguenze dannose quando le agenzie governative non coinvolgono il pubblico nelle discussioni sull'uso appropriato degli ADS prima dell'attuazione.

Questo impegno dovrebbe includere l'opzione per i membri della comunità di decidere le aree in cui non desiderano utilizzare ADS. Esempi di buone pratiche di governo possono includere il prendersi il tempo necessario per garantire che vengano effettuate revisioni di esperti indipendenti e valutazioni d'impatto incentrate sull'uguaglianza e sui diritti umani.

I governi possono adottare diversi approcci per implementare i sistemi ADS in modo più responsabile. Credito:Data Justice Lab, autore fornito

Raccomandiamo di rafforzare la responsabilità per coloro che desiderano implementare ADS richiedendo prove di accuratezza, efficacia e sicurezza, nonché revisioni della legalità. Come minimo, le persone dovrebbero essere in grado di scoprire se un ADS ha utilizzato i loro dati e, se necessario, avere accesso a risorse per contestare e correggere valutazioni errate.

Ci sono un certo numero di casi elencati nel nostro rapporto in cui la partnership di agenzie governative con società private per fornire servizi ADS ha presentato problemi. In un caso, un'agenzia governativa ha deciso di non utilizzare un sistema di impostazione della cauzione perché la natura proprietaria del sistema significava che imputati e funzionari non sarebbero stati in grado di capire perché fosse stata presa una decisione, rendendo impossibile un'efficace sfida.

Le agenzie governative devono disporre delle risorse e delle competenze per esaminare a fondo il modo in cui acquistano i sistemi ADS.

Una politica di cura

Tutte queste raccomandazioni sottolineano l'importanza di una politica di cura. Ciò richiede che coloro che desiderano implementare ADS apprezzino la complessità delle persone, delle comunità e dei loro diritti.

È necessario porre domande chiave su come gli usi dell'ADS portino a punti ciechi a causa del modo in cui aumentano la distanza tra gli amministratori e le persone che dovrebbero servire attraverso sistemi di punteggio e smistamento che semplificano eccessivamente, deducono il senso di colpa, prendono di mira in modo errato e stereotipano le persone attraverso categorizzazioni e quantificazioni.

La buona pratica, in termini di una politica di cura, implica prendersi il tempo per considerare attentamente i potenziali impatti dell'ADS prima dell'implementazione e rispondere alle critiche, garantire una supervisione e una revisione continue e cercare una revisione indipendente e comunitaria. + Esplora ulteriormente

Questo articolo è stato ripubblicato da The Conversation con licenza Creative Commons. Leggi l'articolo originale.