Alex Jones ha affermato che essere deplatform ha danneggiato il suo reddito. Credito:Vic Hinterlang/Shutterstock

Il teorico della cospirazione e personaggio dei media di estrema destra statunitense Alex Jones è stato recentemente condannato a pagare 45 milioni di dollari (37 milioni di sterline) per danni alla famiglia di un bambino ucciso nella sparatoria nella scuola di Sandy Hook del 2012.

Jones aveva affermato che essere bandito o "deplatform" dai principali siti di social media per le sue opinioni estreme lo ha influenzato negativamente finanziariamente, paragonando la situazione alla "carcere". Ma durante il processo, l'economista forense Bernard Pettingill ha stimato che il sito web della cospirazione di Jones InfoWars ha guadagnato più soldi dopo essere stato bandito da Facebook e Twitter nel 2018.

Quindi la deplatform online funziona davvero? Non è possibile misurare l'influenza in modo scientificamente rigoroso, quindi è difficile dire cosa succede all'influenza complessiva di una persona o di un gruppo quando vengono deplatform. Nel complesso, la ricerca suggerisce che il deplatforming può ridurre l'attività di attori nefasti su quei siti. Tuttavia, ha un prezzo. Man mano che persone e gruppi deplatform migrano altrove, possono perdere follower ma anche diventare più odiosi e tossici.

In genere, il deplatforming implica azioni intraprese dagli stessi siti di social media. Ma può essere fatto da terze parti come gli istituti finanziari che forniscono servizi di pagamento su queste piattaforme, come PayPal.

Anche la chiusura di un gruppo è una forma di deplatforming, anche se le persone al suo interno sono ancora libere di utilizzare i siti. Ad esempio, il subreddit The_Donald (un forum sul sito Web Reddit) è stato chiuso per aver ospitato contenuti odiosi e minacciosi, come un post che incoraggiava i membri a partecipare a una manifestazione della supremazia bianca.

Trame di Jhaver et al. Pubblicazione dei livelli di attività e dei punteggi di grave tossicità dei sostenitori di tre celebrità di Twitter deplatform prima e dopo la deplatform.

La deplatform funziona?

La ricerca mostra che la deplatform ha effetti positivi sulla piattaforma da cui la persona o il gruppo è stato espulso. Quando Reddit ha bandito alcuni forum che vittimizzavano persone in sovrappeso e afroamericani, molti utenti attivi su questi subreddit odiosi hanno smesso del tutto di pubblicare su Reddit. Coloro che sono rimasti attivi hanno pubblicato contenuti meno estremi.

Ma il gruppo o la persona deplatform possono migrare. Alex Jones continua a lavorare al di fuori dei principali social network, operando principalmente attraverso il suo sito Web InfoWars e i suoi podcast. Il divieto delle big tech può essere visto come una punizione per aver sfidato lo status quo senza censure, rafforzando i legami e il senso di appartenenza tra i seguaci.

Gab è stato creato come social network alternativo nel 2016, accogliendo utenti che sono stati banditi da altre piattaforme. Dall'insurrezione del Campidoglio degli Stati Uniti, Gab ha twittato su questi divieti come un distintivo d'onore e ha affermato di aver visto un'impennata di utenti e domande di lavoro.

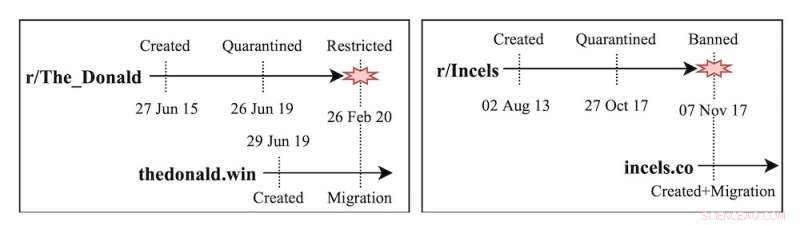

La ricerca del mio team ha esaminato i subreddit The_Donald e Incels (una comunità online maschile ostile nei confronti delle donne), che sono passati a siti Web autonomi dopo essere stati banditi da Reddit. Abbiamo scoperto che quando le comunità pericolose sono migrate su piattaforme diverse, le loro impronte sono diventate più piccole, ma gli utenti sono diventati significativamente più estremi. Allo stesso modo, gli utenti che sono stati bannati da Twitter o Reddit hanno mostrato un aumento del livello di attività e tossicità dopo essersi trasferiti su Gab.

Altri studi sulla nascita di social network marginali come Gab, Parler o Gettr hanno trovato modelli relativamente simili. Queste piattaforme si commercializzano come bastioni della libertà di parola, accogliendo utenti banditi o sospesi da altri social network. La ricerca mostra che non solo l'estremismo aumenta a causa della moderazione lassista, ma anche che i primi utenti del sito hanno un'influenza sproporzionata sulla piattaforma.

Le conseguenze indesiderate del deplatforming non si limitano alle comunità politiche, ma si estendono alla disinformazione sanitaria e ai gruppi di teoria della cospirazione. Ad esempio, quando Facebook ha bandito i gruppi che discutevano di vaccini contro il COVID-19, gli utenti sono andati su Twitter e hanno pubblicato ancora più contenuti anti-vaccino.

Cronologia di creazione, quarantena e messa al bando dei subreddit Incels e The_Donald.

Soluzioni alternative

Cos'altro si può fare per evitare la concentrazione dell'odio online che può incoraggiare la deplatform? I social network stanno sperimentando interventi di moderazione soft che non rimuovono i contenuti né bandiscono gli utenti. Limitano la visibilità del contenuto (divieto ombra), limitano la capacità di altri utenti di interagire con il contenuto (rispondendo o condividendo) o aggiungono etichette di avviso.

Questi approcci stanno mostrando risultati incoraggianti. Alcune etichette di avviso hanno spinto gli utenti del sito a sfatare false affermazioni. La moderata moderazione a volte riduce le interazioni degli utenti e l'estremismo nei commenti.

Tuttavia, esiste il potenziale per pregiudizi di popolarità (agire o ignorare i contenuti in base al brusio che li circonda) su quali argomenti le piattaforme come Twitter decidono di intervenire. Nel frattempo, le etichette di avviso sembrano funzionare in modo meno efficace per i post falsi se sono di destra.

Inoltre, non è ancora chiaro se la moderata moderazione crei ulteriori vie di molestia, ad esempio prendere in giro gli utenti che ricevono etichette di avviso sui loro post o irritare gli utenti che non possono ricondividere i contenuti.

Esempi di moderazione soft su Twitter:etichette di avviso e shadow ban.

Guardando avanti

Un aspetto cruciale del deplatforming è il tempismo. Prima le piattaforme agiscono per fermare i gruppi che utilizzano le piattaforme tradizionali per far crescere i movimenti estremisti, meglio è. Un'azione rapida potrebbe in teoria mettere un freno agli sforzi dei gruppi di radunare e radicalizzare vaste basi di utenti.

Ma ciò richiederebbe anche uno sforzo coordinato da parte delle piattaforme tradizionali e di altri media per funzionare. I talk show radiofonici e i notiziari via cavo svolgono un ruolo cruciale nella promozione di narrazioni marginali negli Stati Uniti

Abbiamo bisogno di un dialogo aperto sul compromesso del deplatforming. Come società, dobbiamo discutere se le nostre comunità debbano avere meno persone esposte a gruppi estremisti, anche se coloro che si impegnano diventano sempre più isolati e radicalizzati.

Al momento, il deplatforming è gestito quasi esclusivamente da grandi aziende tecnologiche. Le aziende tecnologiche non possono risolvere il problema da sole, ma nemmeno i ricercatori o i politici. Le piattaforme devono collaborare con le autorità di regolamentazione, le organizzazioni per i diritti civili e i ricercatori per gestire i contenuti online estremi. Il tessuto della società può dipendere da esso. + Esplora ulteriormente

Questo articolo è stato ripubblicato da The Conversation con licenza Creative Commons. Leggi l'articolo originale.