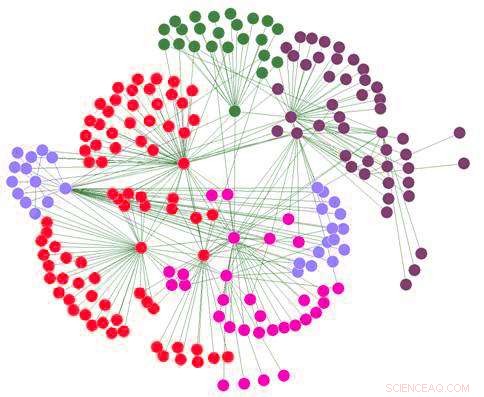

Diagramma della rete sociale. Credito:Daniel Tenerife/Wikipedia

Gli utenti banditi dalle piattaforme social vanno altrove con maggiore tossicità, secondo un nuovo studio condotto da ricercatori della Binghamton University, Università statale di New York.

Quando le persone si comportano da idioti sui social media, una risposta permanente è vietare loro di postare di nuovo. Porta via il megafono digitale, la teoria va, e i messaggi offensivi o disonesti di quei piantagrane non pubblicheranno più un problema lì.

Cosa succede dopo, anche se? Dove vanno coloro che sono stati 'depiattaformati', e come influenza il loro comportamento in futuro?

Un team internazionale di ricercatori, tra cui l'assistente professore Jeremy Blackburn e il Ph.D. La candidata Esraa Aldreabi del Thomas J. Watson College of Engineering and Applied Science's Department of Computer Science, esplora queste domande in un nuovo studio intitolato "Capire l'effetto della depiattaforma sui social network".

La ricerca condotta dai collaboratori di iDRAMA Lab presso la Binghamton University, Università di Boston, L'University College di Londra e il Max Planck Institute for Informatics in Germania è stato presentato a giugno al Conferenza 2021 ACM Web Science .

I ricercatori hanno sviluppato un metodo per identificare gli account appartenenti alla stessa persona su piattaforme diverse e hanno scoperto che essere bannati su Reddit o Twitter ha portato quegli utenti a unirsi a piattaforme alternative come Gab o Parler dove la moderazione dei contenuti è più permissiva.

Tra i risultati c'è anche che, sebbene gli utenti che si spostano su quelle piattaforme più piccole abbiano un pubblico potenzialmente ridotto, mostrano un maggiore livello di attività e tossicità rispetto a prima.

"Non puoi semplicemente vietare queste persone e dire, 'Hey, ha funzionato.' non scompaiono, " Blackburn ha detto. " Vanno in altri posti. Ha un effetto positivo sulla piattaforma originale, ma c'è anche un certo grado di amplificazione o peggioramento di questo tipo di comportamento altrove".

Lo studio deplatforming ha raccolto 29 milioni di post da Gab, lanciato nel 2016 e che attualmente conta circa 4 milioni di utenti. Gab è noto per la sua base di estrema destra di neonazisti, nazionalisti bianchi, antisemiti e teorici della cospirazione di QAnon.

Utilizzando una combinazione di apprendimento automatico ed etichettatura umana, i ricercatori hanno incrociato i nomi dei profili e i contenuti con gli utenti che erano stati attivi su Twitter e Reddit ma sono stati sospesi. Molti di coloro che sono privi di piattaforma riutilizzano lo stesso nome del profilo o le stesse informazioni dell'utente su una piattaforma diversa per continuità e riconoscibilità con i propri follower.

"Solo perché due persone hanno lo stesso nome o nome utente, non è una garanzia, " Blackburn ha detto. "C'è stato un processo piuttosto lungo per creare un set di dati 'ground verità', dove avevamo voce in capitolo umana, "Devono essere le stesse persone per questa ragione e per quella ragione." Ciò ci consente di ampliare le cose inserendolo in un classificatore di apprendimento automatico [programma] che apprenderà le caratteristiche da tenere d'occhio".

Il processo non era diverso dal modo in cui gli studiosi determinano l'identità degli autori per opere non attribuite o pseudonime, controllando lo stile, sintassi e argomento, Ha aggiunto.

Nel set di dati analizzato per questo studio, circa il 59% degli utenti di Twitter (1, 152 su 1, 961) ha creato account Gab dopo la loro ultima attività su Twitter, presumibilmente dopo che il loro account è stato sospeso. Per Reddit, circa il 76% (3, 958 su 5, 216) degli utenti sospesi hanno creato account Gab dopo il loro ultimo post su Reddit.

Confrontando i contenuti degli stessi utenti su Twitter e Reddit rispetto a Gab, gli utenti tendono a diventare più tossici quando sono sospesi da una piattaforma e sono costretti a spostarsi su un'altra piattaforma. Diventano anche più attivi, aumentando la frequenza dei post.

Allo stesso tempo, il pubblico per i contenuti degli utenti di Gab è ridotto dalle dimensioni ridotte della piattaforma rispetto ai milioni di utenti su Twitter e Reddit. Questo potrebbe essere visto come una buona cosa, ma Blackburn ha avvertito che gran parte della pianificazione per l'attacco del 6 gennaio al Campidoglio degli Stati Uniti è avvenuta su Parler, una piattaforma simile a Gab con una base di utenti più piccola che si inclina verso l'alt-right e l'estrema destra.

"Ridurre la portata probabilmente è una buona cosa, ma la portata può essere facilmente fraintesa. Solo perché qualcuno ne ha 100, 000 follower non significano che sono tutti follower nel mondo reale, " Egli ha detto.

"Il gruppo hardcore, forse il gruppo che ci preoccupa di più, sono quelli che probabilmente si attaccano a qualcuno se si sposta altrove online. Se riducendo quella portata, aumenti l'intensità a cui sono esposte le persone che stanno intorno, è come una domanda di tipo qualità contro quantità. È peggio avere più persone che vedono queste cose? O è peggio avere cose più estreme prodotte per meno persone?"

Uno studio separato, "Un grande set di dati aperti dal social network Parler, " includeva anche Blackburn tra i ricercatori della New York University, l'Università dell'Illinois, University College London, Boston University e l'Istituto Max Planck.

Presentato alla Conferenza AAAI su Web e Social Media il mese scorso, ha analizzato 183 milioni di post Parler realizzati da 4 milioni di utenti tra agosto 2018 e gennaio 2021, così come i metadati di 13,25 milioni di profili utente. I dati confermano che gli utenti di Parler, che ha chiuso brevemente ed è stato rimosso dagli app store di Apple e Google in risposta alla rivolta al Campidoglio, hanno sostenuto in modo schiacciante il presidente Donald Trump e il suo programma "Make America Great Again".

«Indipendentemente da quello che avrebbe potuto dire Parler, pubblicamente o meno, era molto chiaramente bianco, ala destra, sostenitori di Trump cristiano, " disse Blackburn. "Di nuovo, non sorprende, ha avuto il suo più grande impulso proprio alle elezioni del 2020:fino a un milione di utenti che si sono iscritti. Poi intorno all'attacco al Campidoglio, c'è stato un altro grande aumento negli utenti. Quello che possiamo vedere è che è stato usato molto chiaramente come strumento organizzativo per l'insurrezione".

Quindi, se vietare gli utenti non è la risposta giusta, Cos'è? Amministratori di Reddit, Per esempio, avere una capacità di "esclusione dell'ombra" che consente agli utenti problematici di pensare che stiano ancora pubblicando sul sito, tranne che nessun altro può vederli. Durante le elezioni del 2020 e la pandemia di COVID-19, Twitter ha aggiunto etichette di moderazione dei contenuti ai tweet che diffondono deliberatamente disinformazione.

Blackburn non è sicuro di tutti gli strumenti di moderazione che le piattaforme di social media hanno a disposizione, ma pensa che ci debbano essere più "soluzioni socio-tecniche ai problemi socio-tecnici" piuttosto che un semplice divieto assoluto.

"La società ora sta dicendo abbastanza fermamente che non possiamo ignorare queste cose:non possiamo più semplicemente usare le uscite facili, " ha detto. "Dobbiamo trovare alcune idee più creative per non sbarazzarci delle persone, ma si spera che li spinga in una direzione positiva o almeno si assicuri che tutti siano consapevoli di chi sia quella persona. Da qualche parte tra l'accesso illimitato e il divieto a tutti è probabilmente la soluzione giusta".